爬蟲機制幫助我們自動化數據處理。它提高了分析效率,讓資源變得更容易獲得。

本文將深入探討爬蟲的基本運作原理和演算法。幫助您全面理解如何利用這項技術進行自動化數據收集和分析。抓住數據時代的機遇。

爬蟲機制原理解析

網路爬蟲是一種自動化程式,用於收集網站資料。它透過預設的規則自動訪問網頁,靈活獲取資訊。這項技術廣泛應用於資料分析和市場研究。

什麼是網路爬蟲?

網路爬蟲的主要功能是自動收集網路上的資料。它使用特定的演算法,快速從各種網站提取內容。這幫助企業快速了解市場動態,提升競爭力。

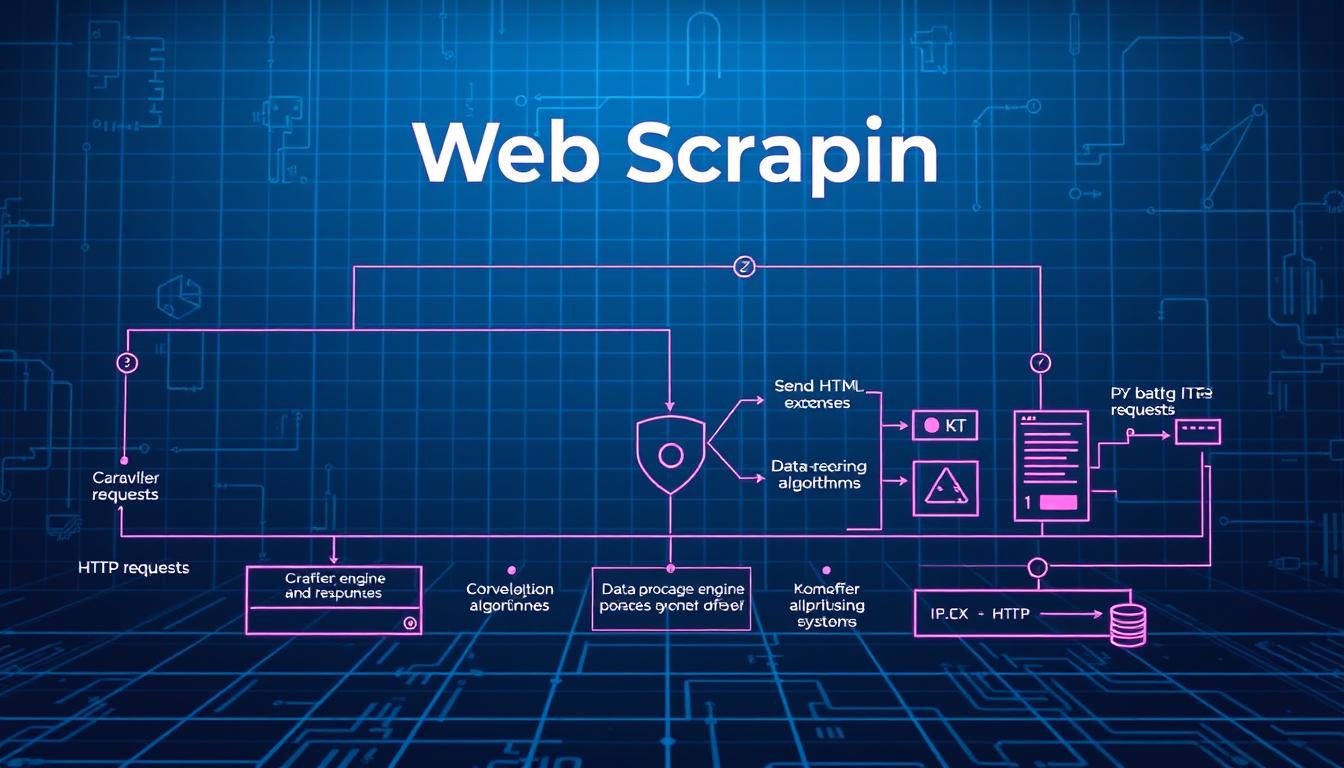

網路爬蟲的運作流程

網路爬蟲的運作流程包括幾個步驟:

- 發送請求至目標網頁,獲取 HTML 內容

- 解析所獲取的 HTML,提取特定資料

- 將提取出的資料存儲在資料庫或文件中,以便進行後續分析

爬蟲演算法介紹

爬蟲演算法是根據特定規則自動搜尋和整理網絡上的資料。它透過不同的方法提高資料處理效率。這樣做可以提高資料提取率,對於建立高效的爬蟲系統非常重要。

基本演算法原理

爬蟲演算法的基本原理包括多種技術。其中,廣度優先和深度優先搜索是最常見的。廣度優先搜索會先探索起始點附近的所有節點。

然後逐步向外擴展。深度優先搜索則是專注於一條路徑,直到無法繼續為止。選擇哪種方法取決於資料處理的需求。

常見的爬蟲演算法

最知名的爬蟲演算法包括Scrapy、BeautifulSoup及Selenium。這些工具各有其獨特功能和優勢。Scrapy適合大規模資料抓取。

BeautifulSoup提供便捷的HTML解析功能。Selenium則能與JavaScript互動,抓取動態內容。選擇合適的演算法能有效提升資料處理效率。

網路爬蟲技術的應用範疇

網路爬蟲技術在商業環境中越來越重要。它幫助企業收集和分析數據,做出更好的決策。電商價格追蹤和輿情監控是它的主要應用。

電商價格追蹤

電商市場競爭激烈,價格差異影響消費者選擇。網路爬蟲技術讓企業能夠監控價格,更新資訊。這幫助企業調整價格策略,了解市場變化。

新聞輿情監控

爬蟲程式設計的基本概念

選擇合適的程式語言

Python是最流行的爬蟲程式設計語言之一。它易於學習,讓新手快速上手。Python還有很多第三方庫,如BeautifulSoup和Selenium。

這些工具大大簡化了網頁資料的提取和操作。

- BeautifulSoup:提供簡潔的方法來解析HTML和XML文件,方便資料爬取。

- Selenium:能自動化網頁操作,適合處理需要使用者互動的網站。

選擇合適的程式語言能提高開發效率。它也確保了爬蟲的穩定性和效能。Python因其強大社群和豐富教學資源,成為許多開發者的首選。

常用的爬蟲工具使用方法

現代的爬蟲技術發展迅速。許多專業工具幫助我們有效擷取網絡資料。BeautifulSoup和Selenium是兩個常見的選擇,它們各有特色。

接下來,我們將介紹這兩種工具的基本用法和使用技巧。

BeautifulSoup的基本用法

BeautifulSoup是一個Python庫,專門用於解析HTML和XML文檔。它能夠方便地提取我們需要的資料。

要使用BeautifulSoup,首先要安裝相關的工具。

- 使用pip安裝BeautifulSoup:pip install beautifulsoup4

- 透過requests庫取得網頁內容:

- 實例化BeautifulSoup並解析HTML:

import requests

url = 'http://example.com'

response = requests.get(url)from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')解析後,可以使用選擇器從HTML中提取標籤或屬性。這非常適合用於靜態網站的資料擷取。

Selenium的使用技巧

Selenium是一款強大的自動化測試工具。它特別適合處理需要操作動態網頁的情況。

它能夠控制瀏覽器執行各種動作。因此,在網絡資料擷取方面表現出色。

- 安裝Selenium:pip install selenium

- 下載對應的瀏覽器驅動,並設定環境變數。

- 寫一個簡單的爬蟲範例:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get("http://example.com")

html_content = driver.page_source爬蟲運作流程的詳細步驟

要了解爬蟲運作流程,首先要知道每個步驟的重要性。爬蟲的流程主要包括幾個核心步驟。這些步驟包括網頁請求、資料解析、信息提取和資料儲存。

首先,網頁請求是爬蟲運作的第一步。這步驟涉及向目標網站發送HTTP請求。請求內容可能包含特定的數據需求。

接著,爬蟲需要解析返回的數據。這樣才能辨識出有價值的信息。利用工具如BeautifulSoup或Selenium,可以有效處理HTML結構,提取所需數據。

爬蟲模組開發指南

在今天的數據驅動世界裡,爬蟲模組開發變得非常重要。這裡,我們會深入探討如何使用Python來開發爬蟲模組。Python因其靈活性和功能強大而非常適合自動化工具的創建。

Python爬蟲模組開發

Python是最受歡迎的爬蟲開發語言之一。它擁有許多庫,這些庫能夠幫助高效開發爬蟲模組。使用Python開發爬蟲有很多優點:

- 它非常簡單易學,適合新手。

- 有許多函數庫,如BeautifulSoup和Scrapy,提供強大的資料解析能力。

- 有著良好的社區支持,能快速獲得幫助和資源。

開發爬蟲模組時,通常會按照以下步驟進行:

- 首先要明確需求,選擇目標網站。

- 然後設計模組架構,劃分功能模塊。

- 接著撰寫爬蟲程式碼並進行測試。

- 最後處理資料,加工結果並儲存。

爬蟲模組開發不僅僅是收集資料。它還能自動化網頁操作,顯著提高工作效率。隨著時間推移,掌握這些技能將為您在資料科學和自動化工具領域開啟無限可能。

如何分析爬蟲資料

Pandas是一款非常適合進行爬蟲資料分析的工具。它能夠有效處理從不同網站爬取的資料。爬蟲所收集的資料經常需要進行清理和標準化,以便後續的數據處理。

Pandas在資料清理中的應用

使用Pandas進行數據清理包括幾個要素。例如刪除重複資料、填補缺失值及格式轉變等。Pandas的DataFrame結構提供了靈活的方式來操作資料集。

- 使用 drop_duplicates() 刪除重複行

- 使用 fillna() 填補缺失值

- 變更數據型別,確保數據一致性

透過這些操作,分析師能夠使爬取的資料更具可用性。這樣可以提升爬蟲資料分析的效率。利用Pandas進行數據處理,能夠將複雜的數據精簡為可理解的資訊。

對於任何需要進行數據處理的專案而言,Pandas都是一個極具價值的工具。它讓業務能夠在數據驅動的世界中蓬勃發展。

如要了解更多有關網絡爬蟲的技術細節,可以參考這裡的進一步探索。這將幫助您深入了解如何高效運用爬蟲所得的資料進行洞察分析。

反爬機制及其破解方法

在網絡世界裡,反爬機制是保護網站安全的關鍵。它包括驗證碼、IP封鎖和使用者行為分析等。這些都是為了阻止不合法的資料抓取。

要成功抓取數據,開發者必須學會破解技術。這樣才能有效地應對網站的防護措施。

網絡安全對企業來說非常重要。反爬機制能防止機密資料洩露,阻止競爭對手獲取有利資訊。開發者可以通過模擬人類行為或使用代理服務來繞過IP限制,提高抓取成功率。

法規與倫理:使用網路爬蟲的注意事項

在使用網路爬蟲時,遵守法律和網路爬蟲倫理很重要。這樣可以避免法律問題,也確保網站運作正常。使用爬蟲技術時,必須考慮網站的目的和規範,特別是robots.txt檔案。

遵守robots.txt的規範

robots.txt是一個協定,規定哪些資源可以被爬蟲訪問,哪些不能。遵循這個規範可以簡化爬蟲工作,保護網站的隱私和資源。這樣做是尊重網站管理者的行為。

未來爬蟲技術的發展趨勢

科技不斷進步,爬蟲技術將展現出許多令人興奮的未來趨勢。自動化將成為核心要素。機器學習和人工智慧的結合將使資料收集過程更加智能化。

隨著自動化水平的提高,爬蟲將能夠更快速地適應變化的網頁結構。它將智能化辨識需要爬取的資料類型。使用者只需設定基本的參數,即可讓系統自動搜索和整理相關信息。

常見的爬蟲技術問題與解決方案

在網頁資料抓取過程中,遇到的技術問題主要包括編碼和格式處理。這些問題可能導致數據無法正確讀取或解析。因此,選擇合適的解決方案非常重要。

針對不同的數據格式,選擇合適的工具是達成資料抓取目標的關鍵。

編碼和格式處理

網絡編碼常常是爬蟲操作中的一大挑戰。不同的網站可能會使用不同的編碼標準。這可能導致在抓取過程中出現亂碼。

確認網頁的正確編碼類型能有效避免這類問題。

資料格式的多樣性也是技術問題之一。例如,HTML、JSON 和 XML 等格式各有其特性。使用針對性強的解析工具,如 BeautifulSoup 或 lxml,可以簡化資料的處理過程。

整合API與爬蟲技術的最佳實踐

在現代網路環境中,API整合與爬蟲技術的結合非常有用。它讓開發人員能夠更高效地獲取資料。這對於成功地管理數據來說非常重要。

爬蟲最佳實踐包括找到合適的API源。這樣可以顯著提高資料獲取的效率。API提供的數據通常比網頁爬取的來得準確和穩定。

網路爬蟲的社群資源與學習途徑

學習網路爬蟲時,社群資源和在線課程非常重要。它們提供從基礎到高級的課程。還有社群討論區,讓開發者可以分享經驗和解問題。

熱門的討論區,如Stack Overflow和Reddit,非常有用。它們幫助你快速了解網路爬蟲的實務挑戰。

在線課程,如Coursera和Udemy,提供網路爬蟲的全面知識。課程包括Python程式設計到數據處理。它們有理論和實作範例,幫助你理解。

社群資源還促進學習者互助。參加線上論壇或社群活動,能擴展人脈。它還讓你了解最新技術和行業動態,保持競爭力。